딥러닝 GPU 성능 비교: GTX 1060부터 1080 Ti SLI까지

🔍 개요: 딥러닝 작업을 위해 GTX 1060, 1070, 1080 Ti, 그리고 1080 Ti SLI 조합의 성능을 비교했습니다. 결론적으로 1080 Ti는 가성비 측면에서 훌륭한 선택이었으며, SLI 구성은 연산 속도보다는 메모리 용량 확장에 더 유용했습니다.

배경: 왜 GPU 업그레이드가 필요했나?

기존에 사용하던 게임용 PC를 딥러닝 연구 목적으로 전환하면서 Ubuntu 18.04를 설치했습니다. 프로젝트를 진행하다 보니 모델 학습 시간이 너무 오래 걸려 GPU 업그레이드가 필요하다고 판단했습니다.

최신 RTX 2070 Super, 2080, 2080 Ti 등은 가격이 너무 비싸서 대안을 찾던 중, 벤치마크 결과를 살펴보니 GTX 1080 Ti가 딥러닝 작업에서도 여전히 좋은 성능을 보이고 있었습니다. 게임이 아닌 딥러닝 목적이었기 때문에, 게임 벤치마크보다는 머신러닝 성능에 초점을 맞추고 싶었지만 관련 자료를 찾기 어려웠습니다.

그래서 직접 테스트를 진행하기로 했습니다.

테스트 환경

기본 시스템 사양

| 구성요소 | 사양 (초기) | 사양 (업그레이드 후) |

| CPU | AMD Ryzen 7 1700 (3.6GHz OC) | AMD Ryzen 5 3600 |

| RAM | Corsair 32GB DDR4 3000MHz OC | 16GB DDR4 2400MHz (RAM RMA 중) |

| OS | Ubuntu 18.04 | Ubuntu 18.04 |

| 케이스 | 미들타워 | 빅타워 (발열 문제로 변경) |

| 전원공급장치 | 원 버전 미상 | 1000W (SLI 구성을 위해 변경) |

테스트한 GPU 구성

- GTX 1060 6GB (기존 GPU)

- GTX 1070 8GB

- GTX 1080 Ti 11GB

- GTX 1080 Ti SLI (11GB x 2)

테스트 방법

GTX 1060 6GB에서 약 90% GPU 사용률을 보이는 딥러닝 코드를 기준으로 각 GPU 구성에서의 성능을 측정했습니다. 완전히 동일한 조건에서 테스트하려 노력했지만, 시간 제약으로 인해 개략적인 성능 차이를 파악하는 데 중점을 두었습니다.

테스트 결과

GTX 1060 6GB

GTX 1060은 기본 구성으로, 학습 시간이 상당히 오래 걸렸습니다. 메모리 제한으로 인해 배치 크기도 제한적이었습니다.

GTX 1070 8GB

GTX 1070은 1060 대비 약 30% 정도 성능이 향상되었습니다. 메모리가 8GB로 늘어나 더 큰 모델과 배치 크기 사용이 가능했습니다.

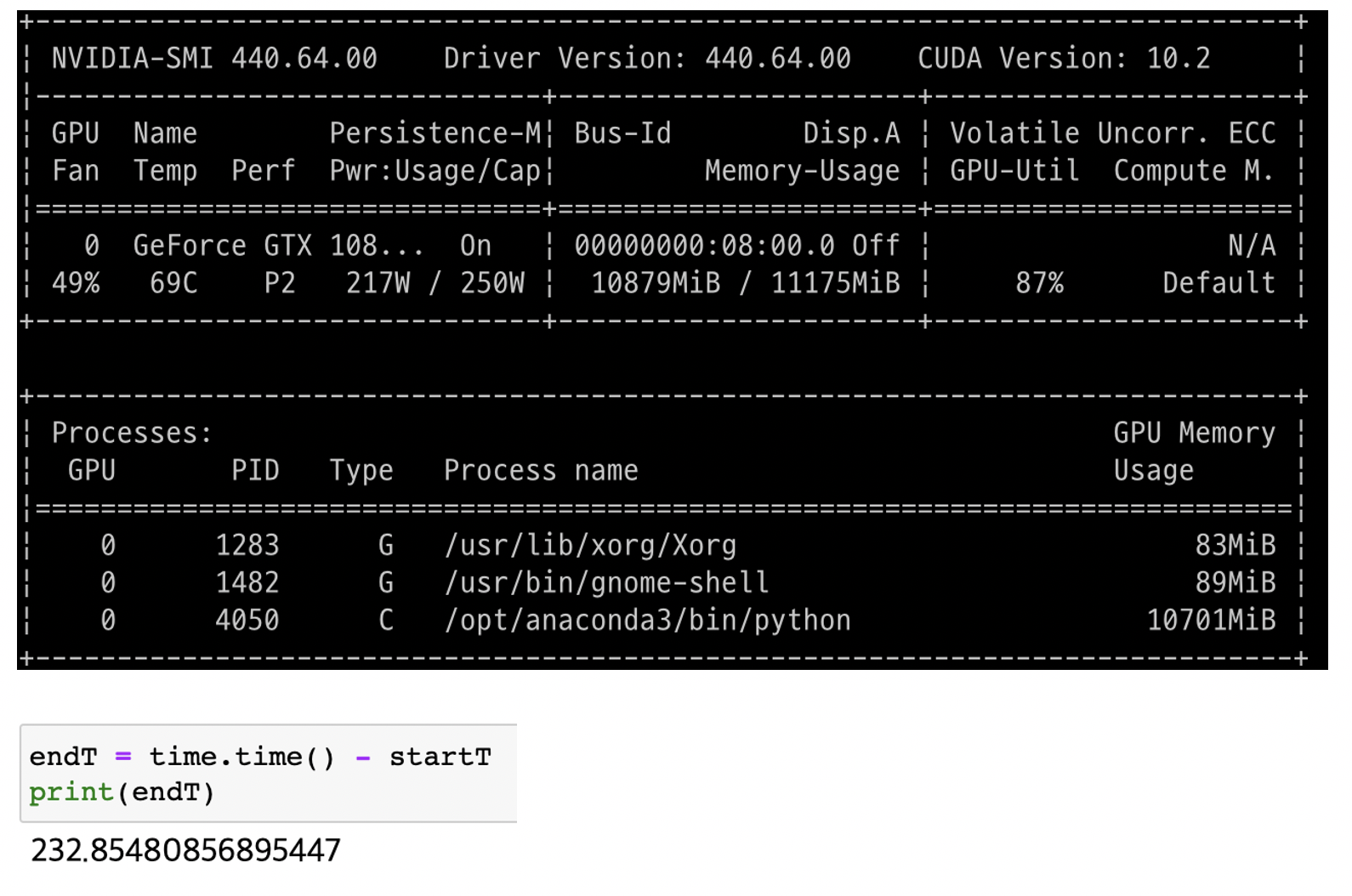

GTX 1080 Ti 11GB

GTX 1080 Ti는 1060 대비 약 2.5배 성능 향상을 보였습니다. 11GB의 대용량 메모리는 복잡한 딥러닝 모델 학습에 큰 도움이 되었습니다.

GTX 1080 Ti SLI

두 개의 1080 Ti를 SLI로 구성했을 때, 메모리 용량은 늘어났지만 놀랍게도 연산 속도 자체는 크게 향상되지 않았습니다. 이 부분은 뒤에서 더 자세히 설명하겠습니다.

1080 Ti SLI 구성의 장단점

장점

- 더 큰 배치 사이즈로 학습 가능

- 더 복잡한 모델 구현 가능

- 여러 모델을 동시에 학습시킬 수 있음

단점

1. 발열 문제

게임은 보통 3-4시간 정도 GPU를 풀로드하지만, 딥러닝 학습은 며칠간 지속될 수 있습니다. 두 개의 1080 Ti가 동시에 풀로드되면 발열이 심각해집니다. 이 문제를 해결하기 위해 미들타워에서 빅타워로 케이스를 변경했지만, 공랭 쿨링의 한계로 큰 개선은 없었습니다.

2. 전력 소비

퀘사이존의 벤치마크 자료에 따르면, 1080 Ti SLI 구성은 순간 최대 650W의 전력을 소비한다고 합니다. GPU당 TDP가 250W인 것을 고려하면 예상보다 훨씬 높은 수치입니다. 이를 위해 1000W 전원공급장치로 업그레이드가 필요했습니다.

3. SLI의 제한적 활용

가장 중요한 발견은 SLI 구성이 딥러닝 연산 속도 자체를 크게 향상시키지 않는다는 점이었습니다. 배치 크기를 늘릴 수 있고 더 많은 메모리를 사용할 수 있지만, 연산 자체의 속도는 크게 개선되지 않았습니다. 3D 렌더링과 같이 SLI를 공식 지원하는 애플리케이션에서는 효과적일 수 있지만, 대부분의 딥러닝 프레임워크에서는 SLI나 NVLink의 이점을 완전히 활용하기 어려웠습니다.

CPU 병목 현상 발견

추가적인 테스트 결과, Ryzen 7 1700과 1080 Ti 조합에서 CPU 병목 현상이 발생했습니다. 이를 해결하기 위해 Ryzen 5 3600으로 CPU를 업그레이드했더니, 동일한 코드 실행 시간이 211초로 단축되었습니다.

사실 Ryzen 7 3700X로 업그레이드했다면 더 좋은 결과를 얻었을 것 같습니다.

현재 RAM이 32GB 3000MHz에서 16GB 2400MHz로 다운그레이드된 상태(RMA 중)이므로, 원래 RAM이 돌아오면 추가 테스트를 진행할 예정입니다.

결론: 가성비 딥러닝 머신

최신 상용 AI 워크스테이션은 수천만 원대의 비용이 들지만, 이런 세대가 지난 파츠들로도 충분히 가성비 좋은 딥러닝 머신을 구성할 수 있었습니다. 특히 GTX 1080 Ti는 딥러닝 작업에 훌륭한 성능을 보여주었습니다.

주요 결론:

- 단일 GPU로는 1080 Ti가 가성비 최고: 현재도 딥러닝 작업에 강력한 성능을 발휘합니다.

- SLI는 제한적 이점: 연산 속도보다는 메모리 용량 확장에 더 유용합니다.

- CPU와 GPU 균형 중요: Ryzen 3000 시리즈와 같은 최신 CPU가 병목 현상을 방지합니다.

- 발열 관리 중요: 장시간 학습 시 발열 관리가 성능과 하드웨어 수명에 큰 영향을 미칩니다.

향후에는 수냉 쿨링 도입을 고려하고 있으며, 발열 문제만 해결된다면 매우 만족스러운 딥러닝 워크스테이션이 될 것 같습니다.

이 글이 가성비 딥러닝 머신을 구성하려는 분들께 도움이 되길 바랍니다. 질문이나 의견은 언제든지 댓글로 남겨주세요!

'AI > Deep Learning' 카테고리의 다른 글

| 딥러닝 성능 최적화: 배치 사이즈가 학습 시간에 미치는 영향 분석 (0) | 2020.06.07 |

|---|---|

| [DL] MNIST 데이터셋으로 U-Net 구현하기: 이미지 노이즈 제거 실험 (1) | 2020.05.07 |

| [DL] GAN과 DCGAN 구현 경험: 적대적 생성 신경망의 학습 과정과 도전 과제 (0) | 2020.04.29 |

| [DL] 딥러닝 서버 구축 3편: 포트포워딩으로 외부에서 서버에 접속하기 (0) | 2020.04.08 |

| [DL] 딥러닝 서버 구축 2편: TensorFlow와 CUDA 버전 충돌 해결하기 (0) | 2020.04.06 |